Arshin Adib-Moghaddam, SOAS, University of London

Bad data does not only produce bad outcomes. It can also help to suppress sections of society, for instance vulnerable women and minorities.

This is the argument of my new book on the relationship between various forms of racism and sexism and artificial intelligence (AI). The problem is acute. Algorithms generally need to be exposed to data – often taken from the internet – in order to improve at whatever they do, such as screening job applications, or underwriting mortgages.

But the training data often contains many of the biases that exist in the real world. For example, algorithms could learn that most people in a particular job role are male and therefore favour men in job applications. Our data is polluted by a set of myths from the age of “enlightenment”, including biases that lead to discrimination based on gender and sexual identity.

Judging from the history in societies where racism has played a role in

establishing the social and political order, extending privileges to white males –- in Europe, North America and Australia, for instance –- it is simple science to assume that residues of racist discrimination feed into our technology.

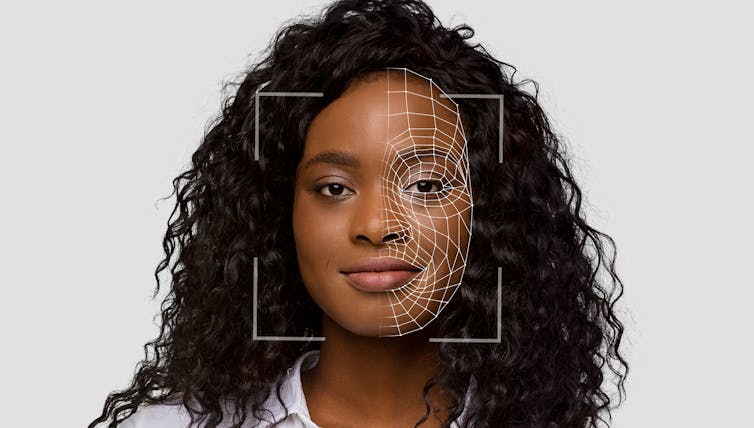

In my research for the book, I have documented some prominent examples. Face recognition software more commonly misidentified black and Asian minorities, leading to false arrests in the US and elsewhere.

Software used in the criminal justice system has predicted that black offenders would have higher recidivism rates than they did. There have been false healthcare decisions. A study found that of the black and white patients assigned the same health risk score by an algorithm used in US health management, the black patients were often sicker than their white counterparts.

This reduced the number of black patients identified for extra care by more than half. Because less money was spent on black patients who have the same level of need as white ones, the algorithm falsely concluded that black patients were healthier than equally sick white patients. Denial of mortgages for minority populations is facilitated by biased data sets. The list goes on.

Machines don’t lie?

Such oppressive algorithms intrude on almost every area of our lives. AI is making matters worse, as it is sold to us as essentially unbiased. We are told that machines don’t lie. Therefore, the logic goes, no one is to blame.

This pseudo-objectiveness is central to the AI-hype created by the Silicon Valley tech giants. It is easily discernible from the speeches of Elon Musk, Mark Zuckerberg and Bill Gates, even if now and then they warn

us about the projects that they themselves are responsible for.

There are various unaddressed legal and ethical issues at stake. Who is accountable for the mistakes? Could someone claim compensation for an algorithm denying them parole based on their ethnic background in the same way that one might for a toaster that exploded in a kitchen?

The opaque nature of AI technology poses serious challenges to legal systems which have been built around individual or human accountability. On a more fundamental level, basic human rights are threatened, as legal accountability is blurred by the maze of technology placed between perpetrators and the various forms of discrimination that can be conveniently blamed on the machine.

Racism has always been a systematic strategy to order society. It builds, legitimises and enforces hierarchies between the haves and have nots.

Ethical and legal vacuum

In such a world, where it’s difficult to disentangle truth and reality from untruth, our privacy needs to be legally protected. The right to privacy and the concomitant ownership of our virtual and real-life data needs to be codified as a human right, not least in order to harvest the real opportunities that good AI harbours for human security.

But as it stands, the innovators are far ahead of us. Technology has outpaced

legislation. The ethical and legal vacuum thus created is readily exploited by criminals, as this brave new AI world is largely anarchic.

Blindfolded by the mistakes of the past, we have entered a wild west without any sheriffs to police the violence of the digital world that’s enveloping our everyday lives. The tragedies are already happening on a daily basis.

It is time to counter the ethical, political and social costs with a concerted social movement in support of legislation. The first step is to educate ourselves about what is happening right now, as our lives will never be the same. It is our responsibility to plan the course of action for this new AI future. Only in this way can a good use of AI be codified in local, national and global institutions.![]()

Arshin Adib-Moghaddam, Professor in Global Thought and Comparative Philosophies, SOAS, University of London

This article is republished from The Conversation under a Creative Commons license. Read the original article.

=======================================

Per facilitare la lettura dell’articolo postiamo una traduzione effettuata con l’assistenza di google translator. Per un utlizzo professionale e/o di studio raccomandiamo di fare riferimento alla versione alla versione alla fonte

For minorities, biased AI algorithms can damage almost every part of life

I dati errati non producono solo risultati negativi. Può anche contribuire a reprimere settori della società, ad esempio le donne vulnerabili e le minoranze.

Questo è l’argomento del mio nuovo libro sul rapporto tra varie forme di razzismo e sessismo e l’intelligenza artificiale (AI). Il problema è acuto. In genere gli algoritmi necessitano di essere esposti ai dati – spesso presi da Internet – per poter migliorare qualunque cosa facciano, come selezionare domande di lavoro o sottoscrivere mutui.

Ma i dati di training spesso contengono molti dei pregiudizi che esistono nel mondo reale. Ad esempio, gli algoritmi potrebbero apprendere che la maggior parte delle persone in un particolare ruolo lavorativo sono uomini e quindi favorire gli uomini nelle domande di lavoro. I nostri dati sono inquinati da una serie di miti risalenti all’età dell’Illuminismo , compresi pregiudizi che portano alla discriminazione basata sul genere e sull’identità sessuale .

A giudicare dalla storia delle società in cui il razzismo ha avuto un ruolo nello

stabilire l’ordine sociale e politico , estendendo i privilegi ai maschi bianchi – in Europa, Nord America e Australia, per esempio – è semplice scienza supporre che residui di discriminazione razzista alimentare la nostra tecnologia.

Nella mia ricerca per il libro, ho documentato alcuni esempi importanti. I software di riconoscimento facciale più comunemente identificano erroneamente le minoranze nere e asiatiche , portando a falsi arresti negli Stati Uniti e altrove.

Il software utilizzato nel sistema di giustizia penale ha previsto che i delinquenti neri avrebbero tassi di recidiva più elevati di loro. Ci sono state false decisioni sanitarie. Uno studio ha rilevato che dei pazienti bianchi e neri a cui è stato assegnato lo stesso punteggio di rischio sanitario da un algoritmo utilizzato nella gestione sanitaria statunitense, i pazienti neri erano spesso più malati delle loro controparti bianche.

Ciò ha ridotto di oltre la metà il numero di pazienti neri identificati per cure extra. Poiché è stato speso meno denaro per i pazienti neri che avevano lo stesso livello di bisogni di quelli bianchi, l’algoritmo ha concluso erroneamente che i pazienti neri erano più sani dei pazienti bianchi ugualmente malati. La negazione dei mutui per le popolazioni minoritarie è facilitata da set di dati distorti. L’elenco potrebbe continuare.

Le macchine non mentono?

Tali algoritmi oppressivi si intromettono in quasi ogni area della nostra vita . L’intelligenza artificiale sta peggiorando le cose, poiché ci viene venduta come essenzialmente imparziale. Ci viene detto che le macchine non mentono. Pertanto, secondo la logica, nessuno è da incolpare.

Questa pseudo-obiettività è fondamentale per l’hype sull’intelligenza artificiale creato dai giganti della tecnologia della Silicon Valley. Lo si evince facilmente dai discorsi di Elon Musk, Mark Zuckerberg e Bill Gates, anche se di tanto in tanto ci mettono in guardia

sui progetti di cui loro stessi sono responsabili.

Sono in gioco diverse questioni legali ed etiche irrisolte. Chi è responsabile degli errori? Qualcuno potrebbe chiedere un risarcimento per un algoritmo che nega loro la libertà condizionale in base alla loro origine etnica, allo stesso modo in cui si potrebbe chiedere un risarcimento per un tostapane esploso in una cucina?

La natura opaca della tecnologia dell’intelligenza artificiale pone serie sfide ai sistemi giuridici che sono stati costruiti attorno alla responsabilità individuale o umana. A un livello più fondamentale, i diritti umani fondamentali sono minacciati, poiché la responsabilità legale è offuscata dal labirinto della tecnologia posto tra i perpetratori e dalle varie forme di discriminazione che possono essere comodamente attribuite alla macchina.

Il razzismo è sempre stato una strategia sistematica per ordinare la società. Costruisce, legittima e rafforza le gerarchie tra chi ha e chi non ha.

Vuoto etico e giuridico

In un mondo simile, in cui è difficile distinguere la verità dalla realtà dalla falsità, la nostra privacy deve essere protetta legalmente. Il diritto alla privacy e la concomitante proprietà dei nostri dati virtuali e reali devono essere codificati come diritti umani, anche al fine di cogliere le reali opportunità che una buona intelligenza artificiale offre per la sicurezza umana.

Ma allo stato attuale, gli innovatori sono molto più avanti di noi. La tecnologia ha superato

la legislazione. Il vuoto etico e legale così creato viene facilmente sfruttato dai criminali, poiché questo nuovo mondo dell’intelligenza artificiale è in gran parte anarchico.

Bendati dagli errori del passato, siamo entrati in un selvaggio west senza sceriffi che controllino la violenza del mondo digitale che avvolge la nostra vita quotidiana. Le tragedie stanno già accadendo quotidianamente.

È tempo di contrastare i costi etici, politici e sociali con un movimento sociale concertato a sostegno della legislazione. Il primo passo è informarci su ciò che sta accadendo in questo momento, poiché le nostre vite non saranno più le stesse. È nostra responsabilità pianificare la linea d’azione per questo nuovo futuro dell’IA. Solo così si potrà codificare un buon uso dell’AI nelle istituzioni locali, nazionali e globali.![]()

Arshin Adib-Moghaddam , Professore di Pensiero Globale e Filosofie Comparate, SOAS, Università di Londra

Questo articolo è ripubblicato da The Conversation sotto una licenza Creative Commons. Leggi l’ articolo originale .